Necesitamos un control de armas de inteligencia artificial para evitar que la nueva Guerra Fría se caliente

Un nuevo libro de Mustafa Suleyman, un pionero en inteligencia artificial, destaca los obstáculos que enfrenta el mundo mientras Estados Unidos y China compiten por la supremacía en una tecnología tan potencialmente peligrosa como la fisión nuclear

Más recientemente, ayudó a Google a crear LaMDA (abreviatura de Language Model for Dialogue Applications), uno de los nuevos y revolucionarios modelos de lenguaje grande (LLM). LaMDA es tan plausible en una conversación que convenció al ingeniero de Google, Blake Lemoine, de que era sensible hasta el punto de ser una persona. Seguramente esa es la esencia de aprobar el “Prueba de Turing”, que lleva el nombre del pionero inglés de la tecnología de la información Alan Turing. El año pasado, Suleyman creó Inflection AI con Reid Hoffman, cuyo libro Impromptu, en coautoría con GPT-4, hablé en mi última columna.

Lo que hace que Suleyman sea inusual en este campo es que no comenzó como científico de datos. Nacido en Islington, al norte de Londres, hijo de un taxista de origen sirio y de una enfermera inglesa, abandonó Oxford para fundar la Muslim Youth Helpline, un servicio de asesoramiento telefónico, y pasó a trabajar para el alcalde socialista de Londres, Ken Livingstone (“Ken el Rojo”). Sus experiencias tanto con el gobierno municipal como con las Naciones Unidas informan sus ideas sobre la probable respuesta política a los desafíos que plantea la IA.

El punto de partida de Suleyman es el familiar e hiperbólico de que la IA va a revolucionar casi todo. “Con la IA, podríamos descubrir los secretos del universo, curar enfermedades que durante mucho tiempo nos han eludido y crear nuevas formas de arte y cultura que trasciendan los límites de la imaginación. … La ola que se avecina es un supercúmulo, un estallido evolutivo como la explosión del Cámbrico, la erupción más intensa de nuevas especies en la historia de la Tierra”.

Mientras leía sus primeros capítulos, me acordé de Por qué la IA salvará el mundo, de Marc Andreessen , el reciente ensayo en el que el titán del capital de riesgo argumenta contra las Casandras y los luditas que la IA no “nos matará a todos, arruinará nuestra sociedad, quitarnos todos nuestros empleos o conducir a una desigualdad paralizante”. Simplemente “hará que sea más fácil para las personas malas hacer cosas malas”, como casi cualquier tecnología nueva.

Pero Suleyman es mucho menos optimista. “Con la IA”, advierte, “podríamos crear sistemas que están fuera de nuestro control y encontrarnos a merced de algoritmos que no entendemos”. Prevé “una amenaza existencial para los Estados nacionales: riesgos tan profundos que pueden perturbar o incluso derribar el orden geopolítico actual”. Teme “inmensos ciberataques potenciados por la IA, guerras automatizadas que podrían devastar países [y] pandemias diseñadas”, sin mencionar “una avalancha de información errónea, la desaparición de empleos y la perspectiva de accidentes catastróficos”.

Esto suena mucho más cercano a otro ex experto en IA de Google, Geoffrey Hinton, quien recientemente dijo a Wired: “Hay ocasiones en las que creo que probablemente no seremos capaces de contenerla [la IA], y simplemente estamos una fase pasajera en la evolución de la inteligencia”. La última sugerencia de Hinton para frenar la revolución de la IA es exigir que se base en computadoras analógicas.

En mis días más optimistas, tengo la esperanza de que los LLM contaminen tanto Internet con sus “alucinaciones” (cosas inventadas que suenan veraces) que todos perdamos la confianza en lo que sea que encontremos en línea. Los LLM ya han comenzado a aprender de las enormes cantidades de contenido que ellos mismos están arrojando, lo que seguramente debe tener consecuencias de entrada y salida de basura. Como ha argumentado Deepak Seth, los LLM ya están recopilando contenido generado por IA y aprendiendo de él. Este proceso tenderá a amplificar las alucinaciones. A principios de este mes, el Wall Street Journal informó que GPT-4 está empeorando en matemáticas. El término técnico para esto es “deriva”, que le da un nuevo significado a la pregunta: “¿Entiendes mi idea?”

Cuanto menos podamos confiar en la verborrea plausible que nos brinda GPT-4, más nos llevarán de regreso a bibliotecas buenas y anticuadas, donde el conocimiento es mucho más confiable y está ordenado racionalmente en lugar de maximizar la participación del globo ocular. Es por eso que mi mayor inversión de los últimos cinco años ha sido en una gran biblioteca estilo “El nombre de la rosa” para albergar libros impresos en papel.

El peligro más inmediato a corto plazo que plantea la IA es para el proceso político democrático. A principios de este verano, Archon Fung y Lawrence Lessig publicaron un escalofriante ensayo en Scientific American, en el que imaginaban una IA llamada “Clogger” decidiendo el resultado de las elecciones presidenciales de 2024.

En primer lugar, su modelo de lenguaje generaría mensajes (textos, redes sociales y correo electrónico, quizás incluyendo imágenes y videos) adaptados a usted personalmente... En segundo lugar, Clogger usaría una técnica llamada aprendizaje por refuerzo para generar mensajes que tienen cada vez más probabilidades de cambiar su voto. … Por último, en el transcurso de una campaña, los mensajes de Clogger podrían evolucionar para tener en cuenta sus respuestas a envíos anteriores y lo que ha aprendido sobre cómo cambiar la opinión de otros.

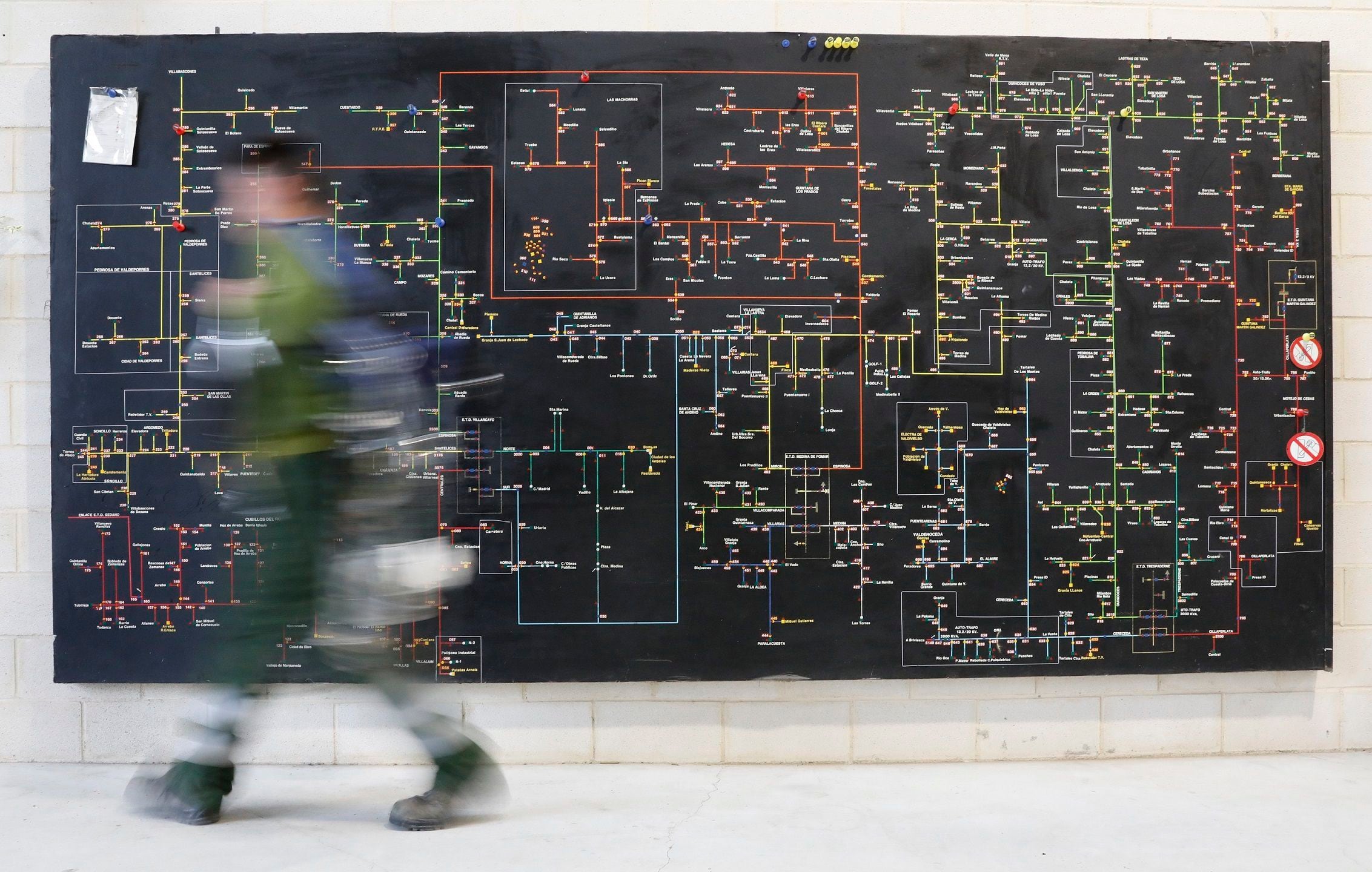

Otro peligro claro y presente es que cada vez más decisiones militares se deleguen a la IA, como ya ocurre en el caso del sistema de defensa antimisiles Cúpula de Hierro de Israel y parece cada vez más una característica de la guerra con drones en Ucrania. La afirmación más cuestionable del ensayo de Andreessen fue su afirmación de que “la IA va a mejorar la guerra, cuando tenga que ocurrir, al reducir drásticamente las tasas de mortalidad en tiempos de guerra”, porque la IA ayudará a los estadistas y comandantes a “tomar decisiones estratégicas y tácticas mucho mejores, minimizando riesgo, error y derramamiento de sangre innecesario”.

Sospecho firmemente que sucederá lo contrario. En las próximas guerras de IA, las tasas de mortalidad en las fuerzas armadas serán muy, muy altas precisamente porque la IA hará que los misiles y otras armas sean mucho más precisos. Cualquier IA medio decente que haya leído a Clausewitz querrá conseguir la aniquilación del enemigo lo antes posible. Los comandantes habilitados por IA también pueden estar más dispuestos a sacrificar a sus propios hombres para asegurar la victoria, de la misma manera que los programas de ajedrez de IA sacrifican sus propias piezas de manera más despiadada que los grandes maestros humanos.

En resumen, estoy de acuerdo con el análisis de Suleyman. La IA (especialmente cuando se combina con la ingeniería genética, la robótica, las computadoras cuánticas, los reactores de fusión y la nanotecnología) implica una proliferación de nuevas tecnologías que son asimétricas, hiperevolutivas, de “omniuso” y autónomas. No todas las consecuencias serán benignas.

El problema es que tal tsunami de cambio tecnológico es casi imposible de contener, y mucho menos de detener. Como sostiene Suleyman, nuestras instituciones políticas carecen de la capacidad para regular la IA. Por un lado, los actores criminales pronto podrán desplegar malware imparable (mucho peor que WannaCry), robots o drones asesinos y motores de desinformación ultrafalsos. Por otro lado, el poder legal se concentra cada vez más en manos de los líderes de unas pocas empresas tecnológicas: las nuevas Compañías de las Indias Orientales. Mientras tanto, la IA está a punto de causar una perturbación masiva en el mercado laboral, destruyendo el contrato social moderno, mediante el cual el Estado-nación liberal del siglo XX ofrecía a sus ciudadanos seguridad y una alta tasa de empleo.

¿Hay algo que podamos hacer para evitar este resultado distópico? En una nueva pieza en coautoría con Ian Bremmer, En Asuntos Exteriores, Suleyman ofrece un ambicioso plan para un régimen “tecnprudencial” internacional para regular la IA. La analogía es en parte con la regulación financiera, como él y Bremmer dejan claro al proponer como modelo potencial “el papel macroprudencial desempeñado por instituciones financieras globales como el Consejo de Estabilidad Financiera, el Banco de Pagos Internacionales y el Fondo Monetario Internacional”. Específicamente, piden la creación de un Consejo de Estabilidad Geotecnológica, similar al Consejo de Estabilidad Financiera creado en abril de 2009, en lo más profundo de la crisis financiera global. Sin embargo, imaginan que las grandes empresas tecnológicas participarán como “partes de cumbres internacionales y signatarias de cualquier acuerdo sobre IA”, lo que implica una participación aún mayor que la que tienen los grandes bancos en la regulación financiera.

Al igual que yo, es posible que usted se sienta inclinado a desesperarse ante la idea de regular la IA tan mal como regulamos las finanzas. Pero nótese los otros dos elementos del modelo de Bremmer-Suleyman. Uno es un organismo similar al Panel Intergubernamental sobre Cambio Climático, para garantizar que tengamos evaluaciones periódicas y rigurosas de los impactos de la IA. El otro es más convincente, en mi opinión.

Washington y Beijing deberían aspirar a crear áreas comunes e incluso barreras de seguridad propuestas y vigiladas por un tercero. Aquí podrían aplicarse los enfoques de vigilancia y verificación que a menudo se encuentran en los regímenes de control de armamentos. … puede haber espacio para que Beijing y Washington cooperen en los esfuerzos globales contra la proliferación.

Esto fue una sorpresa para mí, ya que de The Coming Wave había inferido que Suleyman tenía poco tiempo para analogías entre la IA y las armas nucleares. Él y Bremmer incluso dicen: “Los sistemas de inteligencia artificial no sólo son infinitamente más fáciles de desarrollar, robar y copiar que las armas nucleares; están controlados por empresas privadas, no por gobiernos”. Y, sin embargo, ellos (como casi todos los que intentan pensar sistemáticamente cómo hacer frente a las amenazas que plantea la IA) inevitablemente regresan a la carrera armamentista de la Guerra Fría.

Por supuesto, es una analogía imperfecta. (Imagínese si la bomba atómica hubiera surgido de una competencia en el sector privado entre, digamos, General Electric e IBM. Y la IA tiene muchos más usos y usuarios que la fisión nuclear.) Aún así, no es del todo una coincidencia que la innovación en IA haya tenido muchos más usos y usuarios que la fisión nuclear, se aceleró más o menos simultáneamente con la transición de la relación entre Estados Unidos y China de una simbiosis económica («Quimérica») a una Segunda Guerra Fría. Eric Schmidt, ex director ejecutivo de Google, se mostró escéptico en 2018 cuando sostuve por primera vez que estábamos en una nueva guerra fría, pero el informe final de 2021 de la Comisión de Seguridad Nacional sobre Inteligencia Artificial, que presidió, esencialmente coincide en que:

El ejército estadounidense ha disfrutado de superioridad técnico-militar sobre todos los adversarios potenciales desde el final de la Guerra Fría. Ahora, su destreza técnica está siendo cuestionada, especialmente por China y Rusia. … si no se modifican las líneas de tendencia actuales, el ejército estadounidense perderá su superioridad técnico-militar en los próximos años. … La IA es un aspecto clave de este desafío, ya que nuestras dos grandes potencias competidoras creen que podrán compensar nuestra ventaja militar utilizando sistemas y autonomía habilitados por IA. En las próximas décadas, Estados Unidos ganará contra adversarios técnicamente sofisticados sólo si acelera la adopción de sensores y sistemas de comando y control, armas y logística basados en IA.

El argumento decisivo de Marc Andreessen para perseguir la IA “con la máxima fuerza y velocidad” es que “el mayor riesgo de la IA es que China consiga el dominio global de la IA y nosotros (Estados Unidos y Occidente) no”.

Eso implica, como reconoce Andreessen, una carrera armamentista tan desenfrenada como la que siguió a la adquisición por parte de los soviéticos (a través del espionaje más que de su propia excelencia en física) de la bomba atómica y luego de la bomba de hidrógeno. Es cierto que hoy Estados Unidos está por delante en un aspecto clave: tenemos acceso a los microchips más sofisticados y, gracias a varias sanciones estadounidenses, los chinos no. ¿Pero no coloca esto a Xi Jinping en la posición de Stalin cuando Estados Unidos tuvo la bomba por primera vez?

¿Existe una alternativa a una carrera armamentista total de IA? Es revelador que los mejores ejemplos que el propio Suleyman da de regímenes exitosos de contención tecnológica (una palabra que George Kennan hizo famosa, por supuesto) están tomados de la Primera Guerra Fría: el régimen de no proliferación nuclear y la prohibición de armas químicas y biológicas. Por supuesto, el control de armamentos no fue un éxito absoluto. Pero no logró nada. Y es por eso que Suleyman tiene razón al defenderlo.

Lo que nos lleva de vuelta a “Oppie”. En un artículo reciente aquí, Hal Brands argumentó que Oppenheimer se equivocó al oponerse a la construcción de la bomba de hidrógeno, la “super”, como la conocían los físicos. El argumento de Brand parece ser que la carrera armamentista nuclear estuvo bien porque finalmente los buenos la ganaron. Esto seguramente subestima lo arriesgada que fue esa carrera, sobre todo en 1962, cuando las superpotencias estuvieron a un centímetro de la Tercera Guerra Mundial por Cuba. Al final nos metimos en una situación de locura en la que dedicamos mucho más esfuerzo a construir misiles nucleares que a construir centrales nucleares, ¡como si estas últimas fueran más peligrosas! ¿Es así realmente como queremos que se desarrolle la carrera de la IA?

Bremmer y Suleyman tienen razón: Estados Unidos y China necesitan urgentemente iniciar negociaciones sobre control de armas, no sólo para limitar la utilización de la IA como arma, sino también para garantizar que se destinen más recursos a sus aplicaciones benignas. En este momento, prácticamente no existe ninguna restricción aparte de las restricciones económicas que Estados Unidos ha impuesto a China. Mientras tanto, es muy probable que China siga adelante con la investigación sobre armas biológicas. Como han señalado Schmidt y otros , el riesgo de que la IA se utilice para ese fin es “una preocupación a muy corto plazo”. Nada de lo que estamos haciendo actualmente lo impide; El enfoque actual de la administración Biden hacia China puede incluso estar fomentando dicha actividad.

El equipo de seguridad nacional de Biden cree que puede cambiar el nombre del desacoplamiento económico como “eliminación de riesgos” y luego programar algunas reuniones de alto nivel en Beijing. Pero ese no es el camino hacia una distensión significativa. Estados Unidos y China necesitan hablar sobre cuestiones sustantivas, y el control de armas (no sólo de la IA, sino también de las armas nucleares, biológicas y otras armas de destrucción masiva) es el lugar adecuado para comenzar. De hecho, no me sorprendería que fueran los chinos quienes lo sugirieran. La iniciativa para el control de armamentos en una guerra fría tiende a provenir del lado que teme perder la carrera armamentista.

En cuanto al brillante señor Suleyman, debe tener cuidado. Tiene razón al advertir sobre los peligros de una carrera de IA desenfrenada. Tiene razón al pedir el control de armas de la IA. Pero su argumento a favor de las instituciones globales recuerda al de Oppenheimer en 1946 a favor de una Autoridad de Desarrollo Atómico que limitaría la soberanía nacional con respecto a la tecnología nuclear. Al igual que Oppenheimer, Suleyman tiene un pasado político de izquierda. Y me preocupa que, al igual que Oppenheimer, algún día pueda tener eso en su contra, a medida que la nueva Guerra Fría se intensifica.